Search This Blog

We provide data, new trends, actors, intelligence, market dynamics (drivers, opportunities, restraints, challenges, etc.), analytics, advisory, technologies (apps, software, systems, algorithm, etc.), services, market data (consumers, revenue, investments, capital, etc.), actionable insights, information, consulting, etc.

Posts

Showing posts from April 5, 2011

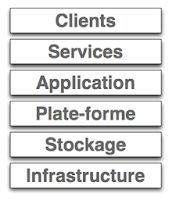

La puissance de calcul et de stockage de l'information , données dans les nuages

- Get link

- X

- Other Apps

Lumière sur le principe générale du web sémantique

- Get link

- X

- Other Apps

empêcher tous les robots sauf Googlebot d'accéder à un dossier en particulier de votre site web

- Get link

- X

- Other Apps

fully cracked Apple’s latest iPhone OS update, iOS 4.3.1(2011)

- Get link

- X

- Other Apps

Autoriser et tous les robots à accéder à tout le site

- Get link

- X

- Other Apps

Lumière sur une interface en Perl permettant de créer des filtres.ta

- Get link

- X

- Other Apps